연합뉴스최근 스타벅스 회사 내부에 가이드라인이 공지됐다. 챗GPT를 비롯한 생성형 AI에 회사의 매출을 비롯한 사내 정보를 입력하지 말라는 것. 직원들이 업무에 챗GPT를 사용할 때 기업 내부 정보 유출이 우려되자, 사측에서 이를 방지하기 위해 선제적으로 가이드라인을 세운 것이다.

연합뉴스최근 스타벅스 회사 내부에 가이드라인이 공지됐다. 챗GPT를 비롯한 생성형 AI에 회사의 매출을 비롯한 사내 정보를 입력하지 말라는 것. 직원들이 업무에 챗GPT를 사용할 때 기업 내부 정보 유출이 우려되자, 사측에서 이를 방지하기 위해 선제적으로 가이드라인을 세운 것이다.

국내 기업들도 챗GPT를 비롯한 생성형 AI를 업무에 적극적으로 활용하고 있다. 하지만 기업 내부 정보 유출을 방지하기 위한 구체적인 가이드라인은 부재한 상황이다. 자체 AI 모델을 구축하거나 보안을 담보할 수 있는 세부적인 지침이 필요하다고 전문가들은 지적한다.

인공지능 3명 중 1명 사용…기업 비밀 유출 우려

인공지능(AI)이 일상화됐다. 2024 인터넷이용실태조사에 따르면 AI 서비스를 경험해 봤다고 답한 응답자는 2021년 32.4%에서 꾸준히 증가해 지난해엔 60.3%로 나타났다. 국민 3명 중 1명이 AI 서비스를 경험해 본 셈이다. 특히 프롬프트(명령어)를 입력하면 텍스트, 이미지, 음악 등을 생성하는 챗GPT와 같은 생성형 AI를 경험해 봤다는 비율도 2023년 17.6%에서 2024년 33.3%로 약 2배 가까이 증가했다.

기업에서도 생성형 AI가 업무에 적극 활용되고 있다. 시장 조사기관 한국IDC가 지난해 10월 공개한 보고서에 따르면 전 세계 기업들의 생성형 AI 사용률은 75%를 육박한다.

문제는 업무에 생성형 AI를 사용하는 과정에서 필연적으로 기업과 관련된 정보를 입력할 수밖에 없다는 점이다. 특히 데이터 분석과 자료 정리 등 업무의 생산성을 높이는 작업을 위해서는 기업 내부 자료와 정보를 AI 모델에 입력해야 한다.

가이드라인 부재…기존 보안으로는 '무용지물'

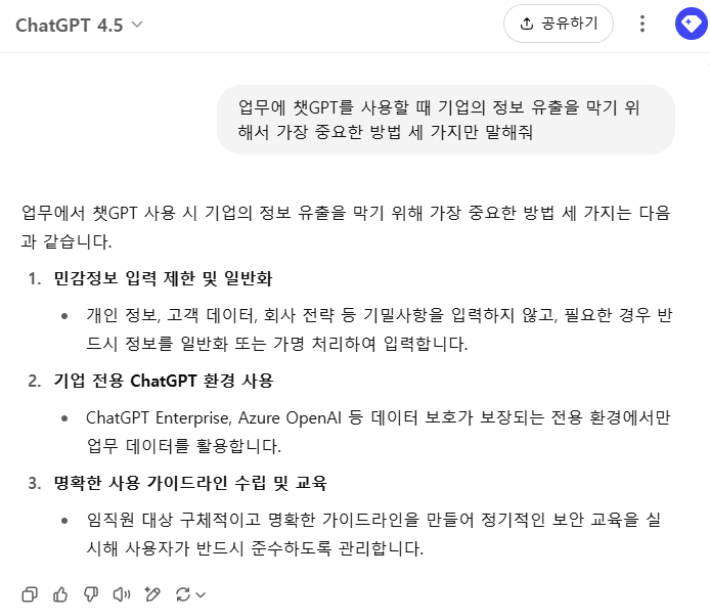

챗GPT에 기업 정보 유출을 방지 방법에 대해 △민감정보 입력 제한 및 일반화 △기업 전용 ChatGPT 환경 사용 △명확한 사용 가이드라인 수립 및 교육이라고 답변했다. 챗GPT 캡처

챗GPT에 기업 정보 유출을 방지 방법에 대해 △민감정보 입력 제한 및 일반화 △기업 전용 ChatGPT 환경 사용 △명확한 사용 가이드라인 수립 및 교육이라고 답변했다. 챗GPT 캡처하지만 AI 사용에 관한 기업 자체적인 가이드라인이 부재한 경우가 대다수다. 지난 2022년 챗GPT가 출시된 지 3년이 지났고 AI를 이용하는 임직원들이 점점 늘고 있음에도 보안의식은 따라오지 못하고 있는 것이다.

가령 LG전자는 정보 유출을 방지하기 위해 내부 메일 서비스를 제공하는 자사 웹메일 페이지 외의 다른 웹사이트에서는 자료를 첨부할 수 없도록 돼 있다. 마찬가지로 챗GPT에서도 파일을 첨부하는 것은 금지되지만, 텍스트 입력은 가능하기 때문에 정보 유출을 막기는 어렵다.

LG전자 한 관계자는 "회사 컴퓨터에 보안 프로그램이 있긴 하지만 생성형 AI 때문에 별도로 보안조치가 강화된 적은 없는 것으로 안다"면서 "회사 정보를 챗GPT에 넣는 것은 지양해야겠지만 막을 수 있는 사실상 방안은 없다"고 말했다.

AI 모델을 직접 개발하고 있는 IT(정보통신) 업계는 비교적 세부적인 지침을 마련하고 있다. 단순 검색과 자료 정리 등 업무를 하는 부서와 AI 개발 부서 각각 활용 수준에 맞는 지침이 세워져 있다. 내부 개발에 필요한 코드는 입력을 금지하는 등의 조항이다.

한 IT 업계 관계자는 "생성형 AI 모델들을 실제로 적용하는 게 업무이기도 하다 보니 무조건 이용을 해야 하는 경우 그에 맞게 가이드라인이 별도로 있다"면서 "AI 사용에 대한 기준을 만드는 부서도 별도로 있다"고 말했다.

AI는 거스를 수 없는 흐름… 자체 AI 마련 필요

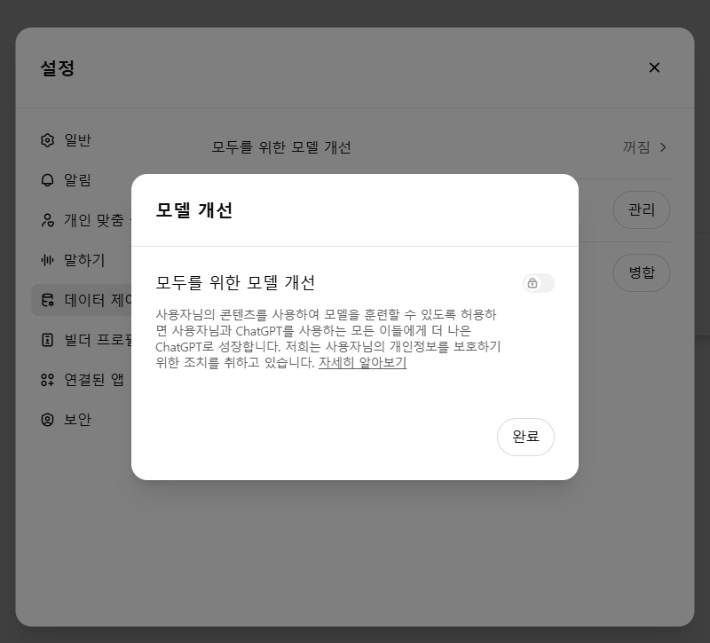

이용자의 콘텐츠를 챗GPT 모델 훈련에 허용하지 허용하지 않기 위해서는 설정→데이터 제어→모두를 위한 모델 개선을 꺼둘 수 있다. 챗GPT 캡처

이용자의 콘텐츠를 챗GPT 모델 훈련에 허용하지 허용하지 않기 위해서는 설정→데이터 제어→모두를 위한 모델 개선을 꺼둘 수 있다. 챗GPT 캡처전문가들은 기업 내부적으로 별도 서버가 있는 AI를 구축하는 방안이 가장 확실하고 안전한 방안이라고 말한다.

김명주 인공지능안전연구소장은 "성능이 조금 떨어져도 작은 모델을 오픈 소스로 가져다 쓸 수 있게 한 모델들이 있다"며 "자체적으로 서버를 마련해 쓰면 바깥에 (정보가) 유출될 걱정을 할 필요가 없다"고 말했다.

국내 기업들 중에서 대표적으로 삼성전자가 지난 2023년 12월부터 기업 내부용 AI 모델을 구축해 이용하고 있다. 앞서 삼성전자 반도체 정보가 챗GPT를 통해 유출됐다는 논란 이후 삼성전자는 챗GPT 사용을 금지한 바 있다.

다만 기업 자체적으로 AI 모델 구축하는 데 시간과 비용이 들고, 그에 비해 성능은 부족해 사실상 활용도가 떨어질 수 있다. 이런 경우에는 임직원들이 많이 이용하는 AI 서비스를 기준으로 가이드라인을 마련해 두는 것이 중요하다는 지적이다.

일례로 챗GPT를 사용할 때 자신의 데이터를 사용해 모델이 훈련되지 않도록 '모두를 위한 모델 개선' 모드를 꺼두도록 해 데이터가 학습돼 외부로 유출되는 것을 방지할 수 있다.

김 소장은 "공공기관용 가이드라인을 감안하거나 기업 별로 맞춤형으로 가공해 제공하는 경우도 있다"며 "최악의 경우 입력하고 있는 데이터가 밖에 나갈 수도 있다는 생각을 해야 한다"고 강조했다.