KAIST 권다희 박사과정, 이세현 박사과정, 최재식 교수(왼쪽부터). KAIST 제공

KAIST 권다희 박사과정, 이세현 박사과정, 최재식 교수(왼쪽부터). KAIST 제공한국과학기술원 (KAIST)는 김재철AI대학원 최재식 교수 연구팀이 AI가 어떤 근거로 판단하는지를 인간이 이해할 수 있도록 보여주는 '설명가능성(XAI)'분야에서, 모델 내부의 개념 형성 과정을 회로 단위로 시각화하는 새로운 XAI 기술을 개발했다고 26일 밝혔다.

이번 연구는 'AI가 어떻게 생각하는지'를 구조적으로 들여다볼 수 있도록 한 중요한 진전으로 평가된다.

딥러닝 모델 내부에는 인간의 뇌처럼 '뉴런'이라는 기본 계산 단위가 존재한다. 뉴런은 이미지 속 작은 특징을 감지하는 기능을 갖고 있으며, 값(신호)을 계산해 다음 단계로 전달한다.

반면 회로는 뉴런 여러 개가 서로 연결되어 하나의 의미(개념)를 함께 인식하는 구조를 말한다. 예를 들어 '고양이 귀'라는 개념을 인식하기 위해서는 귀의 윤곽을 감지하는 뉴런, 삼각형 형태를 감지하는 뉴런, 털 색 패턴을 감지하는 뉴런 등 여러 뉴런이 순차적으로 작동해야 하며, 이들이 하나의 기능 회로를 이룬다.

지금까지의 설명 기술은 '특정 뉴런이 특정 개념을 본다'는 단일 뉴런 중심의 접근이 많았다. 그러나 실제 딥러닝 모델은 여러 뉴런이 협력하는 회로 구조로 개념을 형성하며, 연구팀은 이 점에 착안해 AI의 개념 표현 단위를'뉴런 → 회로'로 확장해 해석하는 기술을 제시했다.

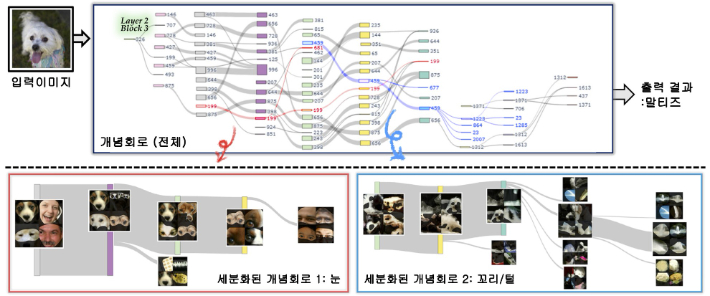

연구팀이 개발한 '세분화된 개념회로(GCC)' 기술은 이미지 분류 모델이 내부에서 개념을 형성하는 과정을 회로 단위로 분석하고 시각화하는 새로운 방식이다.

GCC는 뉴런 민감도, 의미 흐름 점수를 계산해 회로를 자동적으로 추적한다.

KAIST 연구팀에서 제안한 개념회로에 대한 개요. KAIST 제공

KAIST 연구팀에서 제안한 개념회로에 대한 개요. KAIST 제공

연구팀이 특정 회로를 잠시 비활성화(ablation)하는 실험을 수행한 결과, 회로가 담당하던 개념이 사라지면서 AI의 예측이 실제로 달라지는 현상이 나타났다. 해당 회로가 실제로 그 개념을 인식하는 기능을 수행하고 있음을 직접적으로 입증했다.

이번 연구는 복잡한 딥러닝 모델 내부에서 개념이 형성되는 실제 구조를 세밀한 회로 단위로 드러낸 최초의 연구로 평가된다.

이를 통해 AI 판단 근거의 투명성 강화, 오분류 원인 분석, 편향(Bias) 검출, 모델 디버깅 및 구조 개선, 안전성·책임성 향상 등 설명가능성(XAI) 전반에서 실질적인 응용 가능성을 제시했다.

연구팀은 "AI가 내부에서 만드는 개념 구조를 사람이 이해할 수 있는 방식으로 보여주는 기술"이라며 "이번 연구는 AI가 '어떻게 생각하는지'를 과학적으로 연구할 수 있는 출발점"이라고 설명했다.

최재식 교수는 "복잡한 모델을 단순화해 설명하던 기존 방식과 달리, 모델 내부를 세부 회로 단위로 정밀하게 해석한 최초의 접근"이라며 "AI가 학습한 개념을 자동으로 추적·시각화할 수 있음을 입증했다"고 말했다.